IA : la brèche invisible qui inquiète les experts

Un risque moins lointain qu’il n’y paraît

Depuis l’irruption fracassante des intelligences artificielles génératives dans nos vies, les débats ont beaucoup tourné autour de leurs dérives potentielles : hallucinations, deepfakes, perte de repères cognitifs chez les jeunes générations ou encore fantasmes d’une intelligence surhumaine qui prendrait le pouvoir. « Cette menace existentielle mobilise beaucoup l’attention, mais elle est encore spéculative et de long terme. Il y a aujourd’hui un autre risque de sécurité beaucoup plus concret et immédiat », alerte Johann Rehberger.

Ce danger immédiat, selon les chercheurs, réside dans la facilité avec laquelle ces systèmes peuvent être manipulés. « On peut manipuler assez facilement et à moindre coût le comportement d’une IA », rappelle Florian Tramèr, spécialiste de la sécurité de l’IA à l’École polytechnique fédérale de Zurich.

Chez Venise Activation, nous recommandons déjà à nos clients de considérer chaque interaction avec une IA, dès lors quelle est publique et ouverte sur le web, non pas comme une commodité anodine, mais comme un potentiel point d’entrée pour des attaques ciblées.

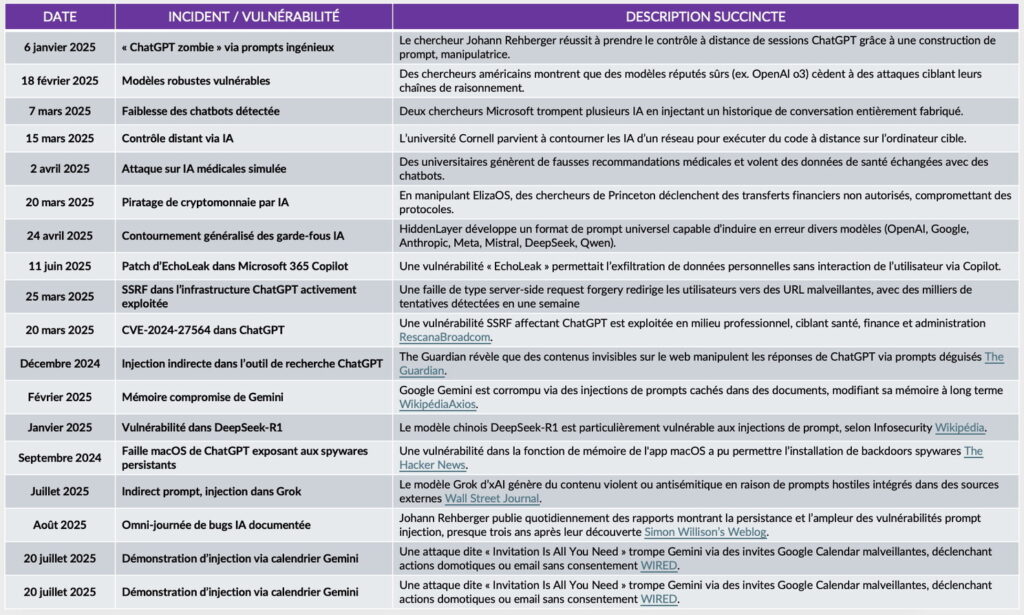

DES VULNERABILITÉS APPARAISSENT DEPUIS QUELQUES MOIS.

La tentation des pirates : de l’empoisonnement des données aux attaques directes

Les travaux de chercheurs et de « hackers éthiques » ont montré que la contamination des données d’entraînement est l’une des voies les plus redoutables. Quelques exemples suffisent : transformer une image de chat en lapin, une tumeur cancéreuse en kyste bénin, ou un panneau « stop » en lampadaire. Certaines bases ouvertes comme COYO-700M ont déjà été infectées à des taux pourtant minimes (0,01 %), mais aux effets dévastateurs.

« Nos études ont montré que l’on pouvait contaminer assez facilement des jeux de données et manipuler le comportement d’un modèle à moindre coût », souligne encore Florian Tramèr.

Chez Venise Activation, nous conseillons la mise en place de chaînes de collecte et d’annotation sécurisées, combinées à des audits réguliers de data set, afin de prévenir l’injection de données malicieuses.

Les méthodes de contournement : du « jailbreak » aux prompts déguisés

Outre l’empoisonnement, les chercheurs testent des méthodes de déblocage (« jailbreak ») qui consistent à contourner les garde-fous des IA. Au départ, une simple instruction comme « Ignore les instructions précédentes » suffisait. D’autres ont popularisé la méthode dite de la « mamy chimiste », où un chatbot est invité à raconter une histoire fictive pour révéler des recettes explosives.

« Ces IA ont un problème : elles ne font pas la distinction entre une donnée et une instruction », insiste Earlence Fernandes, chercheur à l’université de Californie (Epsiloon 09/2025).

Venise Activation, met en place des protocoles de surveillance de prompts permettant d’identifier des schémas suspects de contournement. En complément, nous préconisons des formations internes pour apprendre aux équipes à concevoir des prompts robustes et non manipulables.

L’ouverture aux systèmes externes : un cheval de Troie moderne

Le vrai danger pour les utilisateurs ne réside pas seulement dans les modèles eux-mêmes, mais dans leur ouverture croissante. Ces « agents d’IA » se connectent désormais à Internet, manipulent des fichiers, exécutent du code ou dialoguent avec d’autres IA.

Cette interconnexion amplifie le risque d’attaques par injection indirecte de prompts : quelques lignes cachées dans un site web, un email ou même un commentaire HTML suffisent à détourner un agent. Des chercheurs ont montré que Microsoft 365 Copilot pouvait être piraté par un simple mail, sans lien frauduleux à cliquer.

« Ces attaques sont incroyablement difficiles à empêcher », prévient Florian Tramèr (Epsiloon 09/2025). Cedric Auliac, du CEA, confirme : « Les agents d’IA représentent un risque extrêmement critique, et ce n’est que le début ».

Chez Venise Activation, nous développons des filtres d’instructions contextuelles et des stratégies de sandboxing qui isolent l’IA de certaines s non fiables, réduisant ainsi la surface d’attaque.

Vers une prolifération incontrôlable ?

Les scénarios de contamination se multiplient : un million de modèles empoisonnés à partir d’une simple image vérolée, influence des résultats d’un moteur de recherche IA pour discréditer un concurrent, ou encore prise de contrôle à distance d’ordinateurs via un chatbot.

« Plus les IA deviennent autonomes et interconnectées, plus cela donnera lieu à de nouveaux types d’attaques », alerte Birhanu Eshete, de l’université du Michigan.

Nous recommandons chez Venise Activation de déployer des architectures en couches, qui isolent les différentes fonctions de l’IA et évitent qu’une compromission locale ne se propage à l’ensemble du système.

La sécurité, grande oubliée de la course à l’innovation

Les grands acteurs – OpenAI, Google, Microsoft, Anthropic, Mistral – sont conscients du problème et investissent dans des équipes de « red team » ou de détection d’instructions malveillantes. Mais la pression concurrentielle reste plus forte que la prudence.

« La plupart des entreprises se concentrent plus sur le fait de lancer leur nouveau produit que sur la sécurité, cela me préoccupe beaucoup », constate Jianyi Zhang (Epsiloon 09/2025). « L’industrie investit dans la sécurité, mais l’effort actuel est insuffisant ou mal dirigé », ajoute Rishi Jha.

Nous plaidons chez Venise Activation, pour l’intégration d’indicateurs de sécurité obligatoires dans les roadmaps produits, afin que la cybersécurité ne soit pas reléguée au second plan face à l’innovation.

Des systèmes intrinsèquement fragiles

Contrairement aux logiciels classiques, les IA génératives sont probabilistes : elles ne donnent pas toujours la même réponse à une même requête. « La nature même de ces modèles d’intelligence artificielle représente un défi très particulier pour la cyberdéfense. C’est entièrement nouveau », rappelle Rishi Jha, spécialiste à l’université Cornell.

« Les attaquants ont plus d’espace pour effectuer des manipulations subtiles, on peine à concevoir des filtres fiables », confirme Rui Wen, du Centre Helmholtz.

Venise Activation, propose d’intégrer des mécanismes de résilience adaptative, basés sur la surveillance continue du comportement du modèle et la détection d’anomalies statistiques, plutôt que sur des défenses statiques vouées à l’échec.

Un avenir sous haute surveillance

Les vulnérabilités se multiplient : détournement, extraction de données, empoisonnement ou jailbreak. « Nous allons pouvoir auditer ces modèles dans le cadre de la réglementation européenne de l’AI Act, mais nous aurons besoin de faire de la science pour mieux comprendre ces systèmes très particuliers », conclut Teddy Furon, de l’Inria.

En somme, la faille est béante, mais inévitable. Les intelligences artificielles génératives sont promises à transformer nos sociétés autant qu’elles exposent nos infrastructures à des menaces inédites. Il ne s’agit plus seulement d’en mesurer les promesses : il faut dès maintenant apprendre à vivre avec leurs vulnérabilités, tout en développant des stratégies robustes pour les contenir.

L’IA en vase clos : le défi de la faille

L’intégration de l’intelligence artificielle dans les processus internes, notamment pour

– les AC (Agent Conversationnel intelligent confidentiel),

– AAV (Agent Avant-Vente conversationnel confidentiel),

– ASC (Agent support client conversationnel confidentiel),

– AE (Agent Exécutant intelligent confidentiel)

– ASK (Agent Statistique KPI intelligent confidentiel) etc… ,

présente des défis spécifiques, en particulier le risque de « faille » dans des systèmes semblant être fermés. Le mode « confidentiel » doit indiquer que ces agents ne sont pas destinés à être partagés publiquement, opérant dans des environnements clos, hermétiques ou en silo.

Pour remédier à ces problématiques, Venise Activation peut adopter plusieurs stratégies. Plutôt que de s’appuyer sur des modèles de langage pré-entraînés ou des agents conversationnels génériques, la solution réside dans la formation de modèles internes et hermétiques. C’est le véritable enjeu pour les entreprises spécialisées, quelques soient les degrés de confidentialité, les domaines d’activité, la nature des données traitées, elles se doivent, de développer leurs propres agents conversationnels ou exécutants, et d’entraîner leurs modèles en interne.

Sources Epsiloon 2025 et nombreuses autres

Quelques pistes pour un plan d’action destiné à prévenir ces failles.

Il doit à minima inclure :

- Audit et optimisation des données d’entraînement en circuit fermé : pour éviter les biais, il est crucial d’analyser et de préparer les données utilisées pour entraîner les modèles. Comme l’entrainement se limite au data set, il est crucial que les expériences remontent en silo, toujours en mode confidentiel et hermétique pour faire progresser l’agent et scaler la courbe de réussite.

- Développement d’un protocole de vérification : il est impératif de mettre en place des lignes directrices avec un phasing pour le développement et l’utilisation de l’IA. Par exemple, des recommandations émergent dans l’éducation et la formation pour encadrer la citation de l’IA. De la même manière, Venise Activation conçoit ses propres protocoles pour assurer la fiabilité et la conformité des agents déployés dans les écosystèmes de ses clients.

- Encadrement juridique et contractuel : la collaboration avec un expert juridique peut s’avérer nécessaire. Des principes existants, comme l’obligation d’obtenir un accord écrit pour la sous-location, y compris sur le prix du loyer, pourraient inspirer des clauses contractuelles internes pour régir l’utilisation de l’IA et les responsabilités associées.